Test A/B versus test multivarié : Quel test utiliser ?

Test A/B versus test multivarié : Quel test utiliser ?

Vous avez une étude utilisateur à venir, mais vous ne savez pas quel type de test effectuer entre un test A/B et un test multivarié ? Pour vous aider, nous avons créé un guide vous permettant de choisir le meilleur type de test en fonction de vos besoins.

Table des matières

- Qu’est-ce qu’un test A/B ?

- Quand un test A/B devient-il un test multivarié (MTV) ?

- Les limites des tests A/B et MTV

- Visualisation des tests A/B et A/B/n

- Ce à quoi ressemble un test MTV

- Quand utiliser les méthodes A/B ou MTV et quand ne pas y recourir ?

- Comment mener un test A/B-MTV ?

- Exemple d’étude Sandbox

- Il est temps de commencer !

Avant de commencer, définissons les termes clés utilisés dans cet article.

- Élément : Un aspect de la page, du produit ou du flux à étudier.

Exemple : Si vous étudiez une publicité sur une page Internet, alors les éléments sont le titre, le contenu (texte et/ou graphique), l’appel à l'action (bouton CTA, lien et/ou étiquette), l’arrière-plan de la publicité et ainsi de suite. - Variante : Une version de l’élément.

Exemple : Les variantes d’un élément CTA peuvent être les appels à l'action du lien/bouton « en savoir plus » ou « essayez-le dès aujourd'hui ». - Succès : Une mesure clé.

Exemple : Pour une publicité, la réponse utilisateur peut être un taux de clics, un taux de conversion, un téléchargement, une inscription, etc.

Qu’est-ce qu’un test A/B ?

Le test A/B compare deux variantes d’un élément unique au sein d’une conception unique. Les variantes peuvent être la couleur d’un bouton, l’étiquette sur un bouton ou la position d’un bouton.

Pour que le test AB soit réussi, il est nécessaire que les différences proposées soient des nuances apportées à un seul et unique élément de l’ensemble de la conception. Si vous choisissez d’examiner trois variantes ou plus, le test reste toujours un test A/B, mais nous l’appellerons désormais un test « A/B/n », où n correspond au nombre de variantes.

Quand un test A/B devient-il un test multivarié (MTV) ?

Si nous examinons deux aspects ou plus, d’un élément unique, comme la couleur et l’étiquette d’un bouton. Ou bien si nous examinons deux éléments, comme des variantes de bouton et des variantes de contenu textuel, alors le test est considéré comme un test multivarié, ou MTV, plutôt que A/B/n.

Pour les tests A/B, les modifications sont apportées à un seul et unique aspect d’un élément. Par exemple, l’étiquette d’un bouton peut être modifiée ou sa couleur peut changer. Mais jamais les deux lors d’un même test.

Ainsi, si la même étude teste à la fois l’étiquette et la couleur, alors il s’agit d’un test MTV. Les tests MTV peuvent être très efficaces lorsqu’ils examinent plusieurs éléments de conception, mais ils peuvent également devenir complexes, tant au niveau de la conception de l’étude que de l’analyse.

Les limites des tests A/B et MTV

Les tests A/B et les tests multivariés se concentrent sur des métriques comportementales plutôt que sur des métriques attitudinales (bien que les deux puissent être collectées). Aucun de ces types de tests ne peut examiner des conceptions entièrement différentes (comme deux conceptions différentes de sites Internet), mais seulement des variantes spécifiques des éléments.

Il est possible de tester différentes conceptions générales à l’aide de méthodologies axées sur les attitudes des utilisateurs, comme les méthodes et les outils d'utilisabilité par exemple.

Ainsi, si vous souhaitez tester un design ou une conception de votre interface et non plus des éléments, nous vous conseillons d’utiliser des méthodologies UX, comme les tests modérés, les click-tests et les questionnaires. Ces tests vous permettront d’en savoir plus sur ce que les utilisateurs apprécient et n’apprécient pas sur vos interfaces.

Une fois ces tests réalisés, vous pouvez vous concentrer sur des nuances spécifiques de votre conception en testant des éléments précis à l’aide de tests A/B ou MTV.

Il convient également de ne pas oublier ce que les tests A/B et MTV ne vous diront pas :

- Pourquoi une conception a été préférée à une autre.

- Quels éléments de la conception les utilisateurs apprécient.

- Quels éléments sont désagréables pour les utilisateurs.

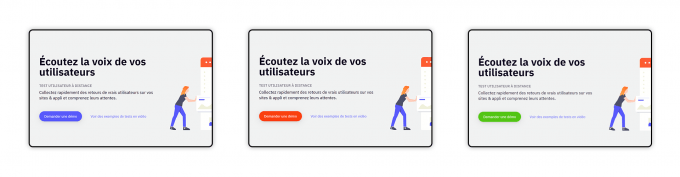

Visualisation des tests A/B et A/B/n

L’image ci-dessous représente un exemple de test A/B/n, où n=3.

Le seul changement est la couleur du CTA « Demander une démo ». Plus de couleurs = plus de « n » :

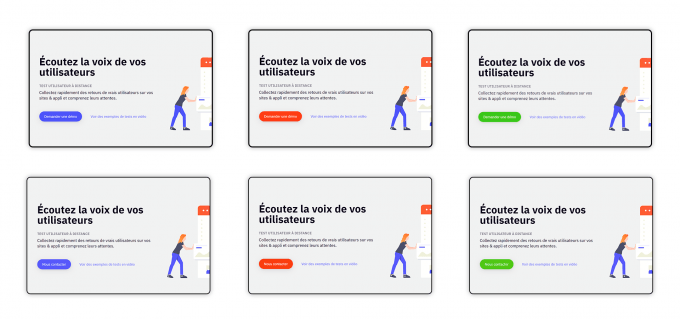

Ce à quoi ressemble un test MTV

Regardons maintenant un exemple de test MTV, où n = 6.

Notez que la modification supplémentaire est la modification de l’appel à l’action « Demander une démo » par « Nous contacter ». Remarquez également que le n a doublé.

Une modification supplémentaire, comme une police de caractères différente ou encore un ajout d’animation, signifie que les variantes augmentent de façon logarithmique, votre « n » explose.

Par conséquent, le nombre de participants nécessaires pour obtenir un résultat valable devient beaucoup plus important. Il faut en effet un nombre de participants raisonnable pour chaque variante, ce qui signifie que l’effort de recrutement peut rapidement devenir impressionnant et qu’il pourrait falloir beaucoup de temps pour collecter les données.

C’est pour cette raison que nous vous conseillons de travailler graduellement, et de ne pas multiplier les variables.

Quand utiliser les méthodes A/B ou MTV et quand ne pas y recourir ?

Une méthodologie A/B peut vous indiquer lequel des deux éléments vous conduit à de meilleurs taux de conversion. Toutefois, beaucoup de choses sont perdues, car vous ne savez pas pourquoi un élément est meilleur que l’autre.

Vous pouvez atteindre davantage de conversions sur le court terme, mais en même temps diminuer la satisfaction de vos utilisateurs en abandonnant des caractéristiques ou des éléments positifs qui existaient dans la conception perdante (vous pouvez également avoir des éléments négatifs dans une conception gagnante dont vous ne connaissez pas l’existence).

Bon pour un test A/B

Utilisez les tests A/B lorsque vous souhaitez savoir, au niveau statistique, de quelle manière une nuance dans votre conception influence le comportement des utilisateurs.

Vous pouvez ajouter dans le test des métriques attitudinales concernant les préférences des utilisateurs, ce qu’ils aiment et n’aiment pas, et autres avis, tout en vous concentrant sur la métrique du comportement utilisateur. C’est la magie de l’hypothèse.

La conversion est toujours la clé

La conversion doit être définie dans votre hypothèse. Concevez votre test afin qu’il se concentre sur la conversion, qui peut être l’achat d'un produit, l’inscription à une newsletter, le téléchargement d’un document, l’inscription à une conférence ou tout autre engagement pris par les utilisateurs.

Bien sûr, un simple clic est rarement une conversion, mais plutôt un parcours vers une conversion éventuelle, qui peut se situer plusieurs étapes en amont dans le processus utilisateur. Configurez donc votre test afin de mesurer à la fois les clics et la conversion réelle.

Comment mener un test A/B-MTV ?

Les étapes de base d’un test A/B-MTV sont simples.

- Document

- Création et exécution

- Analyse et rapport

Jetons un coup d’œil rapide à chaque étape de ce processus :

1. Document

- Indiquez ce que vous testez. Une nouvelle conception, un processus mis à jour, où et quand cela se produit. Ne supposez pas que vos lecteurs aient les mêmes connaissances que vous. Soyez clairs et concis

- Résumez ce que vous savez déjà. Incluez des informations résumées provenant des études passées ou de recherches ou documents externes. Cela prend en compte la recherche utilisateur interne et les travaux de tiers, comme les rapports de Nielsen Norman ou de Forrester.

- Indiquez clairement et distinctement votre hypothèse. Il est essentiel de disposer d’une bonne hypothèse et de définir des métriques pour vérifier vos résultats. Sinon, vous serez dans l’incapacité de valider ou non votre test.

- Répertoriez les dates des tests et les participants cibles.

- Obtenez l'appui des membres de votre équipe. Partagez votre documentation avec eux avant le lancement. Obtenez des retours et des avis et intégrez-les dans votre documentation.

2. Création et exécution

Il est dorénavant temps de créer votre test. Pour cela il est nécessaire de réaliser plusieurs choses :

- Configurez votre critère de succès. Le critère de succès est l’action qui vous permettra de mesurer si vos utilisateurs ont réussi ou non leur parcours. Cela peut être l’arrivée sur un URL X ou bien le fait de cliquer sur un bouton Y. C’est à vous de voir.

- Ajoutez une version de contrôle à votre test. Le but est ici de vérifier les performances de vos hypothèses de tests.

- Ciblez vos participants : Sélectionnez les types de personnes devant participer au test.

- Testez votre test avec des membres de votre équipe pour être sûr de n’avoir rien oublié.

3. Analyses et rapport

Lorsque vous publiez les résultats, faites preuve de clarté, et justifiez tout ce que vous dites à l’aide de vos données.

N’ayez pas peur de dire que vous ne savez pas. Vous pouvez toujours faire plus de tests.

Vous pouvez également utiliser certaines statistiques pour déterminer la confiance que vous avez dans votre augmentation. Vous pouvez avoir une « confiance à 90 % dans une augmentation de 14 % de la conversion avec une erreur estimée à +/- 5 % ». Cela signifie que vous pouvez raisonnablement vous attendre à une amélioration de 9 à 19 % de votre taux de conversion grâce à votre nouvelle conception.

Il est important de partager ce que vous avez appris à partir de votre étude, même si c’est un « échec », partagez avec votre équipe et votre organisation au sens large. N’oubliez pas, ce n’est jamais un échec, c’est toujours un apprentissage.

Votre rapport d’étude doit décrire la réalité de vos résultats, bons ou mauvais. Souvent, la recherche utilisateur est par nature déductive : vous créez une bibliothèque de ce qui ne fonctionne pas, plutôt que de ce qui fonctionne.

Exemple d’étude Sandbox

Jetons maintenant un coup d’œil sur une étude récente que nous avons menée via UserTesting. Nous avons travaillé avec des participants réels, mais avec une marque imaginaire que nous avons créé spécialement pour cet exercice.

1 : Indiquez clairement ce que vous testez

Dans notre exemple, imaginons qu’une entreprise examine un programme appelé TXT.

- TXT est une application qui réside dans le domaine à usage interne uniquement de l'entreprise où le personnel peut discuter de manière anonyme et privée d’informations sensibles à propos de l’entreprise, de son équipe ou de problèmes personnels.

- L’étude examinera les éventuelles options de logo qui pourraient également être utilisées comme icônes à l’écran pour lancer l’application.

- Cette étude n’explore pas le nom de l’application, TXT, ou la fonctionnalité de l’application, seulement le logo.

- Le test suivra la méthodologie A/B/n.

Dans cet exemple, le « contrôle » correspond à la case orange, tandis que le vert et le gris correspondent à nos variantes : B et C.

Il est important de toujours ajouter un contrôle, il s’agira généralement de la conception actuelle, déjà en utilisation.

2 : Prenez en compte ce que vous savez déjà

Il s’agit du premier test de ce type pour le produit.

Listez ici les autres données connues, provenant à la fois de tests internes et de ressources externes.

Par exemple, le groupe Nielsen Norman suggère que les personnes sont plus susceptibles de cliquer sur le vert (le vert utilisé ici est la couleur de la marque de l’entreprise).

Vous pourriez également devoir prendre en compte les problèmes d’accessibilité à ce stade. Vous pouvez utiliser des outils gratuits comme Coblis pour détecter à l’avance tout problème de daltonisme qui pourrait se poser.

3 : Avoir une hypothèse claire

L’énoncé doit être très direct et mesurable.

Dans ce cas, notre hypothèse indiquait : « Nous pensons qu’un pourcentage plus élevé d’utilisateurs cliquera sur la variante B (la case verte). »

Si vous ajoutez des mots comme ET ou CAR, les métriques de votre étude doivent prouver chaque partie de votre hypothèse, les actions et les motivations des utilisateurs.

Les métriques doivent être conformes à l’hypothèse. Dans cet exemple :

- Métriques clés : Nombre de clics utilisateurs uniques vers une variante.

- Des données supplémentaires seront collectées pour évaluer l’expérience utilisateur (évaluations et commentaires).

4 : Les dates de l’étude et les participants

- 45 participants internes seront recrutés pour l’étude.

- L’étude sera lancée le 1er octobre et se poursuivra jusqu’à ce que le quota de participants soit atteint (ou pendant 30 jours, selon la première éventualité).

5 : Documentation et création de rapports

Déterminez comment vous souhaitez partager votre rapport : est-il destiné à un petit groupe de personnes ou doit-il être partagé avec l’ensemble de l’entreprise ?

Vous pouvez choisir la meilleure façon de partager les résultats. Par exemple :

- Si le document est destiné à un petit groupe de personnes, vous pouvez envoyer les données à une adresse e-mail.

- Vous pouvez diffuser plus largement les résultats en utilisant une URL en temps réel et ainsi permettre aux personnes munies d’un lien d’accéder à l’étude en direct.

- Enfin, vous pouvez mettre les résultats finaux à leur disposition via l’intranet ou via votre repository de recherche. Cela permettra à tout le personnel de l’entreprise de se référer facilement aux résultats, maintenant et à l’avenir.

Il est temps de commencer !

Cet exemple devrait vous avoir donné une meilleure compréhension des différences, des avantages (et des limites) des tests A/B et multivariés, ainsi que suffisamment d’informations pour commencer à créer vos propres tests, alors qu’attendez-vous ? Allez-y et testez !

Publié par :

Publié par :